L'objectif du projet H.264/AVC est de créer une norme qui peut fournir une bonne qualité vidéo à un débit binaire bien inférieur aux normes précédentes (c'est-à-dire la moitié du débit binaire de MPEG-2, H.263, ou MPEG- ou Suite). faible). 4 Partie 2), sans augmenter la complexité de la conception, de sorte qu'elle soit peu pratique ou trop coûteuse à mettre en œuvre. Un autre objectif est de fournir suffisamment de flexibilité pour permettre à la norme d'être appliquée à diverses applications sur divers réseaux et systèmes, y compris les débits binaires faibles et élevés, la vidéo basse et haute résolution, la diffusion, le stockage de DVD, le réseau de paquets RTP/IP et l'UIT-T. système téléphonique multimédia. La norme H.264 peut être considérée comme une "famille standard" composée de nombreux fichiers de configuration différents. Un décodeur particulier décode au moins un mais pas nécessairement tous les profils. La spécification du décodeur décrit quels fichiers de configuration peuvent être décodés. H.264 est généralement utilisé pour la compression avec perte, bien qu'il soit également possible de créer des régions de codage véritablement sans perte dans des images codées avec perte, ou de prendre en charge de rares cas d'utilisation où l'ensemble du codage est sans perte.

H.264 a été développé par le groupe d'experts en codage vidéo (VCEG) de l'UIT-T en collaboration avec le groupe d'experts en images animées ISO/IEC JTC1 (MPEG). Le partenariat du projet s'appelle Joint Video Team (JVT). La norme ITU-T H.264 et la norme ISO/IEC MPEG-4 AVC (anciennement ISO/IEC 14496-10-MPEG-4 Part 10, Advanced Video Coding) sont maintenues conjointement afin d'avoir le même contenu technique. La rédaction finale de la première édition de la norme a été achevée en mai 2003, et diverses extensions de ses fonctions ont été ajoutées à ses éditions ultérieures. Le codage vidéo à haute efficacité (HEVC), à savoir H.265 et MPEG-H Part 2, sont les successeurs du H.264/MPEG-4 AVC développé par la même organisation, et les normes antérieures sont encore couramment utilisées.

Le H.264 le plus connu est probablement l'une des normes d'encodage vidéo pour les disques Blu-ray ; tous les lecteurs de disques Blu-ray doivent pouvoir décoder le H.264. Il est également largement utilisé pour diffuser des ressources Internet, telles que des vidéos de Vimeo, YouTube et iTunes Store, des logiciels de réseau tels qu'Adobe Flash Player et Microsoft Silverlight, et diverses émissions HDTV au sol (ATSC, ISDB-T, DVB)-T ou DVB-T2), câble (DVB-C) et satellite (DVB-S et DVB-S2).

H.264 est protégé par des brevets détenus par toutes les parties. Les licences couvrant la plupart (mais pas tous) les brevets nécessaires pour H.264 sont gérées par le pool de brevets MPEG LA. 3 L'utilisation commerciale de la technologie brevetée H.264 nécessite le paiement de redevances à MPEG LA et à d'autres titulaires de brevets. MPEG LA permet l'utilisation gratuite de la technologie H.264 pour fournir aux utilisateurs finaux une vidéo Internet en streaming gratuite, et Cisco Systems verse des redevances à MPEG LA au nom de ses utilisateurs de fichiers binaires encodeur H.264 open source.

1. Nommer

Le nom H.264 suit la convention de nommage ITU-T, qui fait partie de la série H.26x de normes de codage vidéo VCEG ; le nom MPEG-4 AVC est lié à la convention de dénomination dans ISO/IEC MPEG, où la norme est ISO/IEC 14496 Part 10, ISO/IEC 14496 est une suite de normes appelée MPEG-4. La norme a été développée conjointement dans le cadre d'un partenariat entre VCEG et MPEG, et un projet VCEG appelé H.26L a été précédemment réalisé à l'UIT-T. Par conséquent, des noms tels que H.264/AVC, AVC/H.264, H.264/MPEG-4AVC ou MPEG-4/H.264 AVC sont souvent utilisés pour faire référence à la norme afin de souligner l'héritage commun. Parfois, il est aussi appelé "codec JVT", en référence à l'organisation Joint Video Team (JVT) qui l'a développé. (Ce type de partenariat et de dénominations multiples ne sont pas rares. Par exemple, la norme de compression vidéo appelée MPEG-2 est également issue du partenariat entre MPEG et ITU-T, où la vidéo MPEG-2 est appelée par la communauté ITU-T H. 262. 4) Certains logiciels (tels que le lecteur multimédia VLC) identifient en interne cette norme comme AVC1.

2. Histoire

Début 1998, le Video Coding Expert Group (VCEG-ITU-T SG16 Q.6) a lancé un appel à propositions pour un projet appelé H.26L, dans le but de doubler l'efficacité du codage (ce qui signifie que le débit requis réduit de moitié) Un niveau de fidélité donné par rapport à toute autre norme de codage vidéo existante utilisée pour diverses applications. Le VCEG est présidé par Gary Sullivan (Microsoft, anciennement PictureTel, USA). Le premier projet de conception de la nouvelle norme a été adopté en août 1999. En 2000, Thomas Wiegand (Heinrich Hertz Institute, Allemagne) est devenu le coprésident du VCEG.

En décembre 2001, VCEG et le Moving Picture Experts Group (MPEG-ISO / IEC JTC 1 / SC 29 / WG 11) ont formé un Joint Video Group (JVT), et sa charte a finalisé la norme de codage vidéo. [5] La spécification a été formellement approuvée en mars 2003. JVT était présidé par Gary Sullivan, Thomas Wiegand et Ajay Luthra (Motorola, USA : plus tard Arris, USA). En juin 2004, le projet Fidelity Scope Extension (FRExt) a été finalisé. De janvier 2005 à novembre 2007, JVT travaille sur l'extension de H.264/AVC à l'évolutivité via une pièce jointe (G) appelée Scalable Video Coding (SVC). L'équipe de direction de JVT a été élargie par Jens-Rainer Ohm (Université d'Aix-la-Chapelle, Allemagne). De juillet 2006 à novembre 2009, JVT a lancé le codage vidéo multi-vidéo (MVC), qui est une extension de H.264/AVC à la télévision gratuite et à la télévision 3D. Ce travail comprend le développement de deux nouveaux profils standards : Multiview High Profile et Stereo High Profile.

La normalisation de la première version de H.264/AVC a été achevée en mai 2003. Dans le premier projet d'extension de la norme d'origine, JVT a ensuite développé les extensions de plage de fidélité (FRExt). Ces extensions permettent d'obtenir un codage vidéo de meilleure qualité en prenant en charge une précision de profondeur de bits d'échantillonnage plus élevée et des informations de couleur de résolution plus élevée, y compris l'échantillonnage Y'CbCr 4:2:2 (= YUV 4:2:2) et Y 'CbCr 4:4 structure : 4. Le projet Fidelity Range Extensions comprend également d'autres fonctions, telles que la commutation adaptative entre les transformations entières 4 × 4 et 8 × 8, les matrices de pondération de quantification basées sur la perception spécifiées par l'encodeur, l'encodage efficace sans perte entre les images et la prise en charge d'autres espaces colorimétriques. Le travail de conception de Fidelity Range Extensions a été achevé en juillet 2004, et son travail de rédaction a été achevé en septembre 2004.

L'extension récente de la norme comprend l'ajout de cinq autres nouveaux profils [lequel ? ] Principalement utilisé pour les applications professionnelles, ajoutant une prise en charge étendue de l'espace de gamme de couleurs, définissant des indicateurs de rapport hauteur/largeur supplémentaires, définissant deux autres types d'"informations d'amélioration supplémentaires" (indices post-filtre et mappage de tonalité) et supprimant le fichier de configuration FRExt précédent Un (haute 4:4:4), retour d'information de l'industrie [par qui ? ] Les instructions doivent être conçues différemment.

La prochaine fonctionnalité majeure ajoutée à la norme est le codage vidéo évolutif (SVC). Il est stipulé dans l'annexe G de H.264/AVC que SVC permet la construction de flux binaires contenant des sous-flux binaires également conformes à la norme, y compris un tel flux binaire appelé "couche de base", qui peut être décodé par H.264/ Codec AVC qui prend en charge SVC. Pour l'évolutivité temporelle du flux binaire (c'est-à-dire qu'il existe des sous-flux binaires avec un taux d'échantillonnage temporel inférieur à celui du flux binaire principal), des unités d'accès complètes sont supprimées du flux binaire lorsque le sous-flux binaire est dérivé. Dans ce cas, la syntaxe de haut niveau et les images de référence d'interprédiction dans le flux binaire sont construites en conséquence. D'autre part, pour l'évolutivité spatiale et de qualité du flux binaire (c'est-à-dire qu'il existe des sous-flux binaires avec une résolution/qualité spatiale inférieure à celle du flux binaire principal), supprimez NAL du flux binaire lors de la dérivation du sous-flux binaire (couche d'abstraction du réseau). . Dans ce cas, la prédiction intercouche (c'est-à-dire la prédiction d'un signal de résolution spatiale/qualité supérieure à partir de données d'un signal de résolution spatiale/qualité inférieure) est généralement utilisée pour un codage efficace. L'extension de codage vidéo évolutive a été achevée en novembre 2007.

La prochaine fonctionnalité majeure ajoutée à la norme est le codage vidéo multi-vues (MVC). Il est spécifié dans l'Annexe H de H.264/AVC que MVC permet la construction d'un train binaire représentant plus d'une vue d'une scène vidéo. Un exemple important de cette fonctionnalité est l'encodage vidéo 3D stéréoscopique. Deux profils ont été développés dans le cadre du travail MVC : Multiview High Profile prend en charge n'importe quel nombre de vues, et Stereo High Profile est spécialement conçu pour la vidéo stéréo à deux vues. L'extension de codage vidéo Multiview a été achevée en novembre 2009.

3. Demande

Le format vidéo H.264 a une très large gamme d'applications, couvrant toutes les formes de vidéo compressée numériquement, des applications de streaming Internet à faible débit à la diffusion HDTV et aux applications de codage de films numériques presque sans perte. En utilisant H.264, par rapport à MPEG-2 Part 2, le débit binaire peut être économisé de 50 % ou plus. Par exemple, il est rapporté que la qualité de la télévision numérique par satellite fournie par H.264 est la même que la mise en œuvre actuelle de MPEG-2, avec un débit binaire inférieur à la moitié. Le taux d'implémentation actuel de MPEG-2 est d'environ 3.5 Mbit/s, tandis que H.264 n'est que de 1.5 Mbit. /s. [23] Sony affirme que le mode d'enregistrement AVC à 9 Mbit/s équivaut à la qualité d'image du format HDV, qui utilise environ 18-25 Mbit/s.

Afin d'assurer la compatibilité H.264/AVC et une adoption sans problème, de nombreuses organisations de normalisation ont modifié ou ajouté leurs normes relatives à la vidéo afin que les utilisateurs de ces normes puissent utiliser H.264/AVC. Le format Blu-ray Disc et le format HD DVD désormais abandonné utilisent H.264 / AVC High Profile comme l'un des trois formats de compression vidéo obligatoires. Le Digital Video Broadcasting Project (DVB) a approuvé l'utilisation de H.264/AVC pour la diffusion télévisuelle à la fin de 2004.

L'organisme de normalisation américain Advanced Television System Committee (ATSC) a approuvé H.264/AVC pour la télévision diffusée en juillet 2008, bien que la norme n'ait pas encore été utilisée pour les diffusions ATSC fixes aux États-Unis. [25] [26] Il est également approuvé pour la dernière norme ATSC-M/H (mobile/portable), en utilisant les parties AVC et SVC de H.264.

Les marchés de la vidéosurveillance (télévision en circuit fermé) et de la vidéosurveillance ont intégré cette technologie dans de nombreux produits. De nombreux appareils photo reflex numériques courants utilisent la vidéo H.264 contenue dans le conteneur QuickTime MOV comme format d'enregistrement natif.

4. Format dérivé

AVCHD est un format d'enregistrement haute définition conçu par Sony et Panasonic, utilisant H.264 (compatible avec H.264, tout en ajoutant d'autres fonctions et contraintes spécifiques à l'application).

AVC-Intra est un format de compression intra-image développé par Panasonic.

XAVC est un format d'enregistrement conçu par Sony et utilise le niveau 5.2 de H.264/MPEG-4 AVC, qui est le niveau le plus élevé pris en charge par cette norme vidéo. [28] [29] XAVC peut prendre en charge les résolutions 4K (4096 × 2160 et 3840 × 2160) avec des vitesses allant jusqu'à 60 images par seconde (fps). [28] [29] Sony a annoncé que les caméras compatibles XAVC incluent deux caméras CineAlta : Sony PMW-F55 et Sony PMW-F5. [30] Le Sony PMW-F55 peut enregistrer en XAVC, la résolution 4K est de 30 ips, la vitesse est de 300 Mbit/s, la résolution 2K, 30 ips, 100 Mbit/s. [31] XAVC peut enregistrer une résolution 4K à 60 ips et effectuer un sous-échantillonnage de chrominance 4:2:2 à 600 Mbit/s.

5. Traits

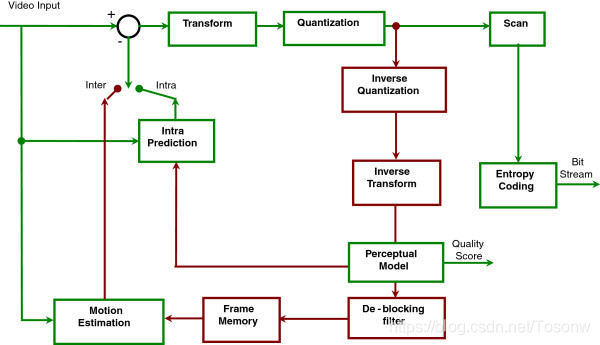

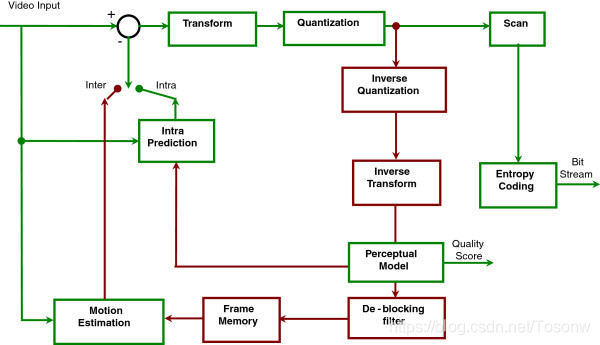

Schéma fonctionnel de H.264

H.264 / AVC / MPEG-4 Part 10 contient de nombreuses nouvelles fonctionnalités qui lui permettent de compresser la vidéo plus efficacement que l'ancienne norme et offrent une plus grande flexibilité pour les applications dans divers environnements réseau. En particulier, certaines de ces fonctions clés incluent :

1) La prédiction inter-images multi-images comprend les fonctionnalités suivantes :

Utilisez des images précédemment codées comme références d'une manière plus flexible que les normes précédentes, permettant l'utilisation de jusqu'à 16 trames de référence (ou 32 champs de référence dans le cas d'un codage entrelacé) dans certains cas. Dans les profils qui prennent en charge les images non IDR, la plupart des niveaux spécifient qu'il doit y avoir suffisamment de mémoire tampon pour autoriser au moins 4 ou 5 images de référence à la résolution maximale. Cela contraste avec les normes existantes, qui ont généralement une limite de 1 ; ou, dans le cas des "images B" traditionnelles (cadres B), deux. Cette fonctionnalité spéciale permet généralement une amélioration modeste du débit binaire et de la qualité dans la plupart des scénarios. [Besoin de citation] Mais dans certains types de scènes, comme les scènes avec des actions répétitives ou des scènes de va-et-vient ou des zones d'arrière-plan découvertes, cela permet de réduire considérablement le débit binaire tout en conservant la clarté.

Compensation de mouvement de taille de bloc variable (VBSMC), la taille de bloc est de 16 × 16, aussi petite que 4 × 4, ce qui permet de réaliser la segmentation précise de la zone en mouvement. Les tailles de blocs de prédiction de luminance prises en charge incluent 16 × 16, 16 × 8, 8 × 16, 8 × 8, 8 × 4, 4 × 8 et 4 × 4, dont beaucoup peuvent être utilisées ensemble dans un seul macro bloc. Selon le sous-échantillonnage de chrominance utilisé, la taille du bloc de prédiction de chrominance est proportionnellement plus petite.

Dans le cas d'un macrobloc B composé de 16 partitions 4×4, chaque macrobloc peut utiliser plusieurs vecteurs de mouvement (un ou deux pour chaque partition) à un maximum de 32. Le vecteur de mouvement de chaque zone de partition 8×8 ou plus peut pointer à une autre image de référence.

Tout type de macrobloc peut être utilisé dans les trames B, y compris les macroblocs I, ce qui permet un codage plus efficace lors de l'utilisation des trames B. Cette caractéristique est visible sur l'ASP MPEG-4.

Filtrage à six touches utilisé pour dériver une prédiction d'échantillon de luminance d'un demi-pixel pour une compensation de mouvement sous-pixel plus claire. Le mouvement d'un quart de pixel est dérivé par interpolation linéaire des valeurs de demi-couleur pour économiser la puissance de traitement.

La précision au quart de pixel utilisée pour la compensation de mouvement peut décrire avec précision le déplacement de la zone en mouvement. Pour la chrominance, la résolution est généralement divisée par deux dans les directions verticale et horizontale (voir 4:2:0), de sorte que la compensation de mouvement de la chrominance utilise une unité de grille de pixel de chroma.

La prédiction pondérée permet à l'encodeur de spécifier l'utilisation de la mise à l'échelle et du décalage lors de l'exécution de la compensation de mouvement, et offre des avantages significatifs en termes de performances dans des situations spéciales, telles que les transitions de fondu entrant et sortant, de fondu entrant et de fondu entrant et de fondu entrant et sortant. Cela inclut la prédiction pondérée implicite des trames B et la prédiction pondérée explicite des trames P.

Prédiction spatiale pour les bords des blocs adjacents pour le codage "intra", au lieu de la prédiction "DC" trouvée dans MPEG-2 Part 2 et la prédiction de coefficient de transformation dans H.263v2 et MPEG-4 Part 2:

Cela inclut des tailles de bloc de prédiction de luminance de 16 × 16, 8 × 8 et 4 × 4 (où un seul type peut être utilisé dans chaque macrobloc).

2) Les fonctions de codage de macrobloc sans perte comprennent :

Le "macrobloc PCM" sans perte représente le mode, qui représente directement les échantillons de données vidéo, [34] permet la représentation parfaite d'une zone spécifique et autorise des restrictions strictes sur la quantité de données codées pour chaque macrobloc.

Le mode de représentation de macrobloc sans perte amélioré permet une représentation parfaite d'une zone spécifique, tout en utilisant généralement beaucoup moins de bits que le mode PCM.

Fonctions d'encodage vidéo entrelacées flexibles, notamment :

Le codage de trame adaptative de macrobloc (MBAFF) utilise une structure de paire de macroblocs pour l'image codée en tant que trame, permettant 16 × 16 macroblocs en mode trame (par rapport à MPEG-2, où le traitement en mode trame est implémenté dans l'image Codage en tant que trame conduit au traitement de semi-macroblocs 16×8).

Le codage de trame et de champ adaptatif d'image (PAFF ou PicAFF) permet de mélanger et de coder des images librement sélectionnées en tant que trame complète, où deux champs sont combinés pour l'encodage ou en un seul champ.

Nouvelles fonctionnalités de conception de conversion, notamment :

Transformée de bloc spatial 4 × 4 entier correspondant exactement, permettant un placement précis des signaux résiduels, presque pas de "sonnerie" commune dans les conceptions de codec précédentes. Cette conception est similaire dans son concept à la bien connue transformée en cosinus discrète (DCT), qui a été introduite en 1974 par N. Ahmed, T. Natarajan et KR Rao, et c'est une référence 1 dans la transformée en cosinus discrète. Cependant, il est simplifié et fournit un décodage spécifié avec précision.

Correspondance précise des transformations de blocs spatiaux entiers 8 × 8, permettant une compression plus efficace des régions hautement corrélées que les transformations 4 × 4. La conception est similaire dans son concept à la DCT bien connue, mais est simplifiée et fournie pour fournir un décodage spécifié avec précision.

Sélection adaptative de l'encodeur entre des tailles de blocs de transformation 4×4 et 8×8 pour les opérations de transformation d'entiers.

Une transformation de Hadamard secondaire est effectuée sur les coefficients "DC" de la transformation spatiale principale appliquée aux coefficients DC de chrominance (et dans un cas particulier également la luminance) pour obtenir encore plus de compression dans la région lisse.

3) La conception quantitative comprend :

Contrôle de la taille du pas logarithmique, gestion plus simple du débit binaire et mise à l'échelle de la quantification inverse simplifiée via l'encodeur

La matrice de mise à l'échelle de la quantification personnalisée en fréquence sélectionnée par l'encodeur est utilisée pour l'optimisation de la quantification basée sur la perception

Le filtre de déblocage de boucle permet d'éviter l'effet de bloc commun à d'autres technologies de compression d'image basées sur DCT, afin d'obtenir une meilleure apparence visuelle et une meilleure efficacité de compression

4) La conception du codage entropique comprend :

Codage arithmétique binaire adaptatif au contexte (CABAC), un algorithme de compression sans perte d'éléments syntaxiques dans un flux vidéo qui connaît la probabilité des éléments syntaxiques dans un contexte donné. CABAC compresse les données plus efficacement que CAVLC, mais nécessite plus de traitement pour les décoder.

Codage de longueur variable adaptatif au contexte (CAVLC), qui est une alternative de complexité inférieure au CABAC utilisé pour coder les valeurs de coefficient de transformation quantifiées. Bien que la complexité soit inférieure à CABAC, CAVLC est plus raffiné et plus efficace que les méthodes couramment utilisées pour coder les coefficients dans d'autres conceptions existantes.

Une technique de codage à longueur variable (VLC) simple et hautement structurée utilisée pour de nombreux éléments de syntaxe non codés par CABAC ou CAVLC est appelée codage exponentiel de Golomb (ou Exp-Golomb).

5) Les fonctions de récupération des pertes comprennent :

La définition de la couche d'abstraction du réseau (NAL) permet d'utiliser la même syntaxe vidéo dans de nombreux environnements réseau. Un concept de conception très basique de H.264 consiste à générer des paquets de données autonomes pour supprimer les en-têtes en double, tels que le code d'extension d'en-tête (HEC) de MPEG-4. Ceci est réalisé en découplant les informations relatives à plusieurs tranches du flux multimédia. La combinaison de paramètres avancés est appelée un jeu de paramètres. [35] La spécification H.264 comprend deux types de jeux de paramètres : le jeu de paramètres de séquence (SPS) et le jeu de paramètres d'image (PPS). L'ensemble de paramètres de séquence effectif reste inchangé dans toute la séquence vidéo codée, et l'ensemble de paramètres d'image effectif reste inchangé dans l'image codée. La structure de l'ensemble de paramètres de séquence et d'image contient des informations telles que la taille de l'image, le mode de codage facultatif adopté et le mappage de groupe de macrobloc à tranche.

L'ordre flexible des macroblocs (FMO), également connu sous le nom de groupe de tranches, et l'ordre arbitraire des tranches (ASO), est une technique utilisée pour reconstruire l'ordre de la représentation des régions de base (macroblocs) dans une image. Généralement considérés comme des fonctions de robustesse aux erreurs/pertes, FMO et ASO peuvent également être utilisés à d'autres fins.

Le partitionnement de données (DP), une fonction qui peut diviser les éléments de syntaxe les plus importants et les moins importants en différents paquets de données, peut appliquer une protection contre les erreurs inégales (UEP) et d'autres types d'améliorations de la robustesse aux erreurs/pertes.

Tranche redondante (RS), une fonctionnalité de robustesse pour les erreurs/pertes, qui permet à l'encodeur d'envoyer une représentation supplémentaire de la zone d'image (généralement avec une fidélité inférieure), qui peut être utilisée si la représentation principale est corrompue ou perdue.

Numéro de trame, permettant la création d'une fonction "sous-séquences", réalisant une évolutivité temporelle en incluant éventuellement des images supplémentaires entre d'autres images, et détectant et masquant la perte de l'image entière, qui peut être causée par une perte de paquet réseau ou de canal. Une erreur s'est produite.

Les tranches de commutation, appelées tranches SP et SI, permettent à l'encodeur de demander au décodeur de passer au flux vidéo en cours à des fins telles que la commutation de débit binaire de flux vidéo et les opérations en "mode astuce". Lorsque le décodeur utilise la fonction SP/SI pour sauter au milieu du flux vidéo, il peut obtenir une correspondance exacte avec l'image décodée à cette position dans le flux vidéo, malgré l'utilisation d'une image différente ou aucune image du tout, comme référence précédente. changer.

Un processus automatique simple utilisé pour empêcher la simulation accidentelle du code de démarrage, qui est une séquence de bits spéciale dans les données codées, permet un accès aléatoire au flux de bits et restaure l'alignement des octets dans les systèmes où la synchronisation des octets peut être perdue.

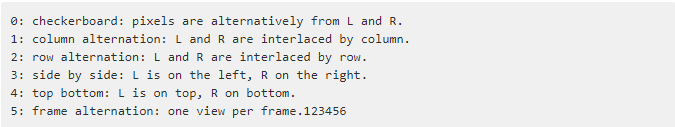

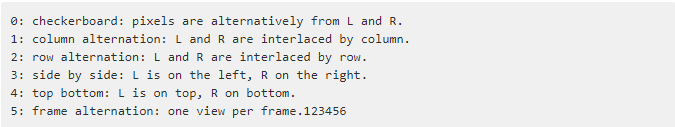

Les informations d'amélioration supplémentaires (SEI) et les informations d'utilisation vidéo (VUI) sont des informations supplémentaires qui peuvent être insérées dans le flux binaire pour améliorer la vidéo à diverses fins. [Clarification nécessaire] SEI FPA (Frame Encapsulation Arrangement) contient un arrangement 3D de messages :

Image auxiliaire, qui peut être utilisée pour la synthèse alpha et à d'autres fins.

Prend en charge le sous-échantillonnage de chrominance monochrome (4:0:0), 4:2:0, 4:2:2 et 4:4:4 (selon le profil sélectionné).

Prend en charge la précision de la profondeur de bits d'échantillonnage, allant de 8 à 14 bits par échantillon (selon le profil sélectionné).

Capable d'encoder chaque plan de couleur en différentes images avec sa propre structure de tranche, son mode macrobloc, son vecteur de mouvement, etc., permettant l'utilisation d'une structure parallèle simple pour concevoir l'encodeur (seuls trois fichiers de configuration prenant en charge 4:4:4 sont pris en charge ) .

Le comptage de séquences d'images est utilisé pour maintenir l'ordre des images et les caractéristiques des valeurs d'échantillon dans l'image décodée isolées des informations de synchronisation, permettant au système de transporter et de contrôler/modifier les informations de synchronisation séparément sans affecter le contenu du image décodée.

Ces technologies et plusieurs autres technologies permettent au H.264 d'être plus performant que n'importe quelle norme précédente dans divers environnements d'application et dans diverses situations. H.264 fonctionne généralement mieux que la vidéo MPEG-2, généralement la même qualité à la moitié du débit binaire ou moins, en particulier à des débits binaires élevés et des résolutions élevées.

Comme les autres normes vidéo ISO/IEC MPEG, H.264/AVC dispose d'une implémentation logicielle de référence qui peut être téléchargée gratuitement. Son objectif principal est de fournir des exemples de fonctions H.264/AVC, pas une application utile en soi. Le Motion Picture Experts Group effectue également des travaux de conception de matériel de référence. Ce qui précède sont les fonctionnalités complètes de H.264/AVC, couvrant tous les fichiers de configuration de H.264. Le profil d'un codec est un ensemble de caractéristiques du codec, qui est identifié pour répondre à un certain ensemble de spécifications pour l'application envisagée. Cela signifie que certains fichiers de configuration ne prennent pas en charge la plupart des fonctions répertoriées. Les différents fichiers de configuration de H.264/AVC seront abordés dans la section suivante.

Notre autre produit: